2017年の深層学習動向と予測

私は前のブログに次の年の予測を書いていました。私が最後に書いたのは、2011年のソフトウェア開発動向と予測でした。それはかなり前のことです。10の予測のうち、私は6つの予測(つまり、Javascript VM、NoSQL、Big Data Analytics、プライベートクラウド、Inversion of Desktop Services、Scala)を得ているが、残りの4つは十分なトラクションを得ていないAppStore、Semantic Indexing、企業内のOAuth、プロアクティブエージェント)。実際、AppStoresとOAuthは大企業では発生しませんが、中小企業はこのSaaSモデルを全面的に採用しています。予測の失敗をチョークして、遅い企業が実際にどのように変化するかを予測できないようにします。残りの2つの予測、セマンティック索引付けとプロアクティブエージェントの予測、私が当初計画していたように残念ながら進歩していません。私はその時のAI技術を過度に推測しているかもしれません。当時、ディープラーニングは発明されていなかった。 ディープ・ラーニングの予測は、私の以前の予測と同じ概念レベルではありません。私は企業の採用を予測するつもりはありませんが、むしろ研究動向と予測に焦点を当てるつもりです。間違いなく、ディープラーニングはAIの採用を企業に促します。まだ岩の下に住んでいる人にとって、ディープ・ラーニングはAIにとって最も重要なアプローチであるという事実です。しかし、それほど明白でないのは、2017年にどのような新しい機能が発生し、指数関数的な導入につながるかということです。 だからここに2017年の私の恐ろしい予測が来る。

1.ハードウェアは、ムーアの法則(すなわち、2017年に2倍)を倍増させるでしょう。

これは、もちろん、NvidiaとIntelの開発状況を追跡すると完全に明らかです。Nvidiaは2017年全体で最も豊富なDeep Learningエコシステムを備えているため、スペースを支配します。DLのために開発されたエコシステムが十分にあるまで、正しい考え方の誰も他のプラットフォームにジャンプしません。Intel Xeon Phiソリューションは到着時にDLに応答して死んでいます。最高でも、ネルバナ由来のチップが発売される2017年中頃までに、彼らはNvidiaのパフォーマンスに追いつくかもしれません。 インテルのFPGAソリューションは、単に経済性のためにクラウドプロバイダーの採用を見るかもしれません。消費電力は、削減が必要な変数の1つです。IntelのNervanaベースのチップは、2017年半ばまでに30テラフロップでクロックインする可能性が高い。これは私の推測ですが、今日はすでに20テラフロップスになっているので、2018年までインテルに大きなインパクトがあるとは思っていません。インテルが持つ唯一の大きなエースは、3D XPoint技術です。これは、ハードウェアスタック全体を改善するのに役立ちますが、パフォーマンス上の理由から、GPUがチップの上にスタックされたHBM2を使用することを考慮すると、必ずしもコアアクセラレータ機能ではありません。 AmazonはFPGAベースのクラウドインスタンスを発表しました。これは、ザイリンクスUltraScale +テクノロジに基づいており、1回のインスタンスで6,800個のDSPスライスと64 GBのメモリを提供しています。これは素晴らしい機能ですが、HBMバージョンのUltraScale +を提供しないことでI / O制限を受ける可能性があります。Nvidia、Intel、さらにはAMDと比較してメモリ帯域幅の低いソリューションは、開発者がより複雑な開発プロセス(VHDL、Verilogなど)に投資するかどうかを中断する可能性があります。 最近のニュースでは、AMDはディープ・ラーニング・アクセラレータの新しいAMD Instinctラインを発表しました。これらの仕様は、Nvidiaハードウェアと比較して非常に競争力があります。この製品は、2017年初頭に発売される予定です。これはおそらく、AMD ROCmソフトウェアが成熟するのに十分な時間であるはずです。

2.畳み込みネットワーク(CNN)が支配する

CNNは、DLシステムの普及したパン・アンド・バター・モデルとなるでしょう。再構成と埋め込みメモリノードを持つRNNとLSTMは、CNNベースのソリューションと競合しないため、あまり簡単に使用されません。GOTOがプログラミングの世界で姿を消したように、RNNs / LSTMでも同じことが期待されます。実際、パラレル・アーキテクチャは、パフォーマンスにおいてシーケンシャル・アーキテクチャを凌駕します。 微分可能なメモリネットワークがより一般的になります。これは、メモリがコアノードからリファクタリングされ、計算コンポーネントとは別のコンポーネントとして存在するアーキテクチャの自然な結果です。補助的な微分可能なメモリに置き換えることができるLSTM用の入力ゲートと出力ゲートを忘れる必要はありません。私たちはすでにLSTMをリファクタリングしてメモリを切り離す会話を見ています(拡張メモリRNNを参照)。

3.デザイナーはMeta-Learningにもっと頼ります

ディープ・ラーニングの旅を始めると、最適化アルゴリズム、特に2次の最適化アルゴリズムが大幅に改善されると思っていました。今日、執筆は壁に、DLは今あなたのための最適化アルゴリズムを学ぶことができます。SGDのより良いバージョンを検討している人にとっては、これが終わりです。SGDのより良いバージョンは、マシンで学習されたもので、手元の問題に固有のものです。メタ学習は、そのドメインに基づいて学習を適応的に最適化することができます。さらにこれに関連して、バックプロパゲーションに対する代替アルゴリズムが実際に現れ始めるかどうかが問題となる。2017年に手をつけたSGDアルゴリズムが最後の足にある可能性があります。

4.強化学習はより創造的になります

現実に関する観察は常に不完全なままです。SGDが適用されない場合、多くの問題があります。これにより、DLシステムの実用的な展開には何らかの形式のRLが必要になることが必須です。これに加えて、私たちはDLトレーニングの多くの場所で使用されるRLを見ていきます。例えば、メタラーニングは、RLによって大きく有効にされる。事実、RLはさまざまな種類のニューラルネットワークアーキテクチャを見いだしてきました。これは、ステロイドでのハイパーパラメータ最適化のようなものです。Gaussian Processビジネスに参加した場合、あなたのランチはちょうど食べられました。

5.敵対的で協力的な学習が王様になる

昔、単一の解析目的関数を持つモノリシックなDLシステムがありました。新しい世界では、2つ以上のネットワークが協力しているか、競合するシステムが分析的な形ではない最適なソリューションに到達することを期待しています。「ゲーム理論はディープラーニングの未来を明らかにする」を参照。2017年には、非平衡の状況を管理しようとする際に多くの研究が行われます。研究者がGANとの非平衡状態を処理する方法を見つけようとしているところでは、すでにこれを見ることができます。

6.予測学習や教師なし学習はあまり進まない

「予言的学習(Predictive Learning)」は、ヤン・ルクンがより一般的な用語である「教師なし学習」に代わる新しい流行語です。この新しい用語が採用されるかどうかは不明です。教師なし学習または予測学習が2017年に大きな進歩を遂げるかどうかという疑問。私の現在の感覚は、それがうまくいかなければならないかについての大規模な概念的切断があるように見えることではないということです。 前回の「5つのディープ・ラーニング・インテリジェンスの機能」を読んだら、Predictive Learningは私が提案したモデルに靴ひもをつける必要がある完全に未知の機能だと感じました。予測学習は宇宙論者ダークマターのようなものです。私たちはそれがそこにあることを知っていますが、私たちはそれを見る方法を知らないだけです。私の感慨深さは、高いエントロピーやそれ以外の場合のランダム性と関係があるということです。 7.移転学習は工業化につながる Andrew Ngはこれが重要だと思っています。私もそうだと思います! 8.より多くのアプリケーションはディープラーニングをコンポーネントとして使用します ディープラーニングがはるかに大きな検索アルゴリズムで機能評価コンポーネントとして使用されていることを2016年に確認しました。AlphaGoは、その価値観と政策評価においてDeep Learningを採用しました。GoogleのGmail自動返信システムでは、DLをビーム検索と組み合わせて使用していました。私は、新しいエンドツーエンドの訓練されたDLシステムではなく、これらのハイブリッドアルゴリズムをもっと多く期待しています。エンドツーエンドのディープラーニングは研究の魅力的な領域ですが、現在はハイブリッドシステムがアプリケーション分野でより効果的になるでしょう。 9.デザインパターンがますます採用される ディープラーニングは、概念的な構造を必要とする複雑な分野の1つにすぎません。すべての先進的な数学にかかわらず、正式な厳密さではなく、ソフトウェア開発のような他の複雑な領域で効果的であることが証明された方法で最もよく捕捉できる手振れやファジィな概念が数多くあります。デリバリーとデザインのパターンに関しては、実践者が最終的に「得る」と予測しています。これは、ディープ・ラーニング・アーキテクチャーがモノリシックではなくモジュラーになっているという事実によってさらに動機づけられます。 エンジニアリングは理論を上回ります 研究者と彼らが採用している数学的ツールの背景は、研究アプローチにおける一種の偏りの育成場です。ディープラーニングシステムと教師なし学習システムは、これまでに遭遇したことのない新しいタイプの可能性があります。したがって、従来の分析ツールはDLが実際にどのように動作するかについての謎を解明する助けとなるという証拠はありません。物理学には数十年の間に悩まされている力学系がたくさんありますが、私は動的学習システムに関しても同じ状況を見ています。 しかし、このような状況は、ファンダメンタルズの理解が不足しているにもかかわらず、さらに高度なアプリケーションの設計を妨げることはありません。ディープラーニングは、バイオテクノロジーや遺伝子工学のようなものです。私たちはシミュレートされた学習マシンを作成しましたが、どのように動作するか正確にはわかりませんが、誰もそれを革新することを妨げていません。

参考

ディープ・マインドのPathNet:AGIのモジュール型ディープ・ラーニング・アーキテクチャ

PathNetは、Modular Deep Learning、Meta-Learning、Reinforcement Learningを融合させてより優れたDLに導くDL研究の最新動向を明らかにする、DeepMind以外の誰があなたにもたらした新しいModular Deep Learning(DL)アーキテクチャです。システム。 2017年1月20日、Arxivの論文「PathNet:スーパーニューラルネットワークにおける進化チャネルグラディエント降下」(Fernando et al。)に、抽象的な次の興味深い記述があります。 人工総合知能(AGI)の場合、巨大な忘却を伴うことなく、複数のユーザが同じ巨大なニューラルネットワークを訓練し、パラメータの再利用を可能にすると効率的である。 PathNetはこの方向の第一歩です。それはニューラルネットワークに組み込まれたエージェントを使用するニューラルネットワークアルゴリズムであり、そのタスクはネットワークのどの部分を新しいタスクに再利用するかを発見することです。 従来のモノリシックDLネットワークとは異なり、PathNetは多くのニューラルネットワークで構成されたネットワークを再利用し、複数のタスクを実行するようにトレーニングします。著者の実験では、ネットワークが最初から訓練された場合よりも、第2のタスクで訓練されたネットワークがより早く学習することが示されています。これは、この種のネットワークで転送学習(または知識の再利用)を活用できることを示しています。 PathNetには、転送学習、継続学習、マルチタスク学習の側面が含まれます。これらは、より継続的に適応可能なネットワーク、したがってAGI(投機的)につながる可能性のあるアプローチに不可欠な側面です。 アーキテクチャを調べてみましょう:

https://arxiv.org/pdf/1701.08734v1.pdf

採用された技術をよりよく理解することができます。 PathNetは、階層内の各ネットワーク間の相互接続が異なる検索方法によって発見されるニューラルネットワークの階層からなる。上記の図では、構成は一度に1つのレイヤーにつき4つのネットワークを選択するように制約されています。この論文では、遺伝的アルゴリズム(進化的アルゴリズム)とA3C強化学習に基づくアルゴリズムの2つの発見アルゴリズムについて説明します。 著者たちは「Google Brainからの「大規模な大規模なニューラルネットワーク」」と「Convolutional Neural Fabrics」との類似点からインスピレーションを得ました。 大規模なニューラルネットワークは、次のように説明されています。 最新のGPUクラスタでの計算効率のわずかな損失だけで、モデル容量の1000倍を超える改善を達成しました。我々は、数千のフィードフォワードサブネットワークで構成されたまばらにゲートされたMixed-of-Expertsレイヤー(MoE)を導入します。訓練可能なゲーティングネットワークは、各例で使用するこれらの専門家の疎結合を決定します。私たちは、モデリング能力とトレーニングコーパスで利用できる膨大な知識を吸収するためにモデル能力が重要な言語モデリングと機械翻訳のタスクにMoEを適用します。本発明者らは、積み重ねられたLSTM層間に畳み込まれて1370億個のパラメータを有するMoEが適用されるモデルアーキテクチャを提示する。 重要なアーキテクチャーコンポーネントは、次のように示されています。

https://arxiv.org/pdf/1701.06538v1.pdf

これは、専門家の混合物から選択する条件付き論理構成要素を示す。 これまでの記事「条件付きロジックは新しいDLの暑さである」のDLの条件付きロジックについて説明しました。 ここでの基本的な考え方は、条件付きコンポーネントを使用することができれば、コンテキストに依存する異なるエキスパートで動作するより大きなネットワークを構築できることです。 したがって、単一のコンテキストはネットワーク全体の小さなサブセットを使用します。 コンボリューション・ニューラル・ファブリックは、ハイパーパラメータ調整の代替アプローチです。

https://arxiv.org/pdf/1606.02492.pdf

つまり、複数の異なる構成を実行し、何がうまくいくかを発見するのではなく、ファブリックは、より大きなネットワークで異なるパスを試行し、最適なパスを見つけようとしながら、ネットワークで以前に発見された最適なサブパスを同時に再利用しようとします。上の図は、ネットワークがファブリック内にどのように埋め込まれているかを示しています。また、このアプローチは、異なるネットワークアーキテクチャを探索する以前に公開されたメタ学習技術の変形として考えることもできる。 前回の記事「DL予測2017」では、#3メタ学習、#4強化学習、#5反対&協調学習、#7移動学習の4つの新興トレンドを指摘しました。 PathNetがどのようにして4つのトレンドを単一の大きなフレームワークに組み込んでいるように見えるかは、単に魅力的です。ここで見ていることは、これらの異なるアプローチを融合すれば、斬新で有望な新しいアーキテクチャにつながる可能性があるということです。 PathNetアーキテクチャは、より適応性のあるDLアーキテクチャへのロードマップも提供します。 DLモノリシックアーキテクチャはトレーニング後に非常に堅牢で、展開すると固定されたままです。これは、継続的に学習している生物学の脳とは異なります。 PathNetを使用すると、新しいコンテキストを同じ時間に学習することができ、他のコンテキストでのトレーニングの知識を活用してより迅速に学習できます。 これらの新しいアーキテクチャは、ディープ・ラーニング・ハードウェアを最適に設計する方法についての新たな考え方につながるかもしれません。まばらに相互接続された大規模なニューラルネットワークネットワークは、一度に多くのサブネットワークの電源を切ることができるため、より効率的なシリコンを設計する機会があることを意味します。

参考

opencvの動画まとめ

車の検出

www.youtube.com

どの車が何台通ったかを検出

www.youtube.com

スピードの判定

www.youtube.com

車両追跡

www.youtube.com

車線判定

www.youtube.com

www.youtube.com

テニス

www.youtube.com

歩行検出

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

文字検出

www.youtube.com

www.youtube.com

AR tool kit

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

www.youtube.com

家の設計図

www.youtube.com

迷路

www.youtube.com

www.youtube.com

ホログラム

www.youtube.com

単一ニューロン分解能で脳をマッピングする革新的な方法が成功裏に実証されました

脳の「供給源」領域への注射は、軸索経路に沿ってバーコードを運ぶように設計された遺伝子工学的タンパク質に突き当たる多様なバーコード配列をコードするウイルスライブラリーを含む。もっと

脳の「供給源」領域への注射は、軸索経路に沿ってバーコードを運ぶように設計された遺伝子工学的タンパク質に突き当たる多様なバーコード配列をコードするウイルスライブラリーを含む。もっと

神経科学者は、今日、マウス脳内で成功裏に実証された個々のニューロンの分解能で、脳をマッピングする革新的な新しい方法についてNeuronの詳細を発表しています。

MAPseq(SequencingによるProjections of Multiplexed Analysis)と呼ばれるこの新しい方法は、単一の実験において、特定の領域または領域からの多数の個々のニューロンの長距離予測を脳内のどこに導くことができるかを可能にします現行のマッピング技術に比べて何倍も安価で、労働集約的で時間のかかる実験が可能です。 多くの重要な脳マッピングプロジェクトが現在進行中であるが、「コネクトム」または配線マップを得るためのこれらの努力のすべては、顕微鏡および関連する光学機器を使用して、ニューロンを他のニューロンにリンクする無数の糸状突起を追跡し、近く、遠い。初めて、MAPseqは脳マッピングのタスクをRNAシークエンシングの1つに変換します」とその発明者であるCold Spring Harbor LaboratoryのAnthony Zador博士は述べています。 「RNA配列やバーコードは、個々のニューロンに与えられるもので、ユニークなものです」とZador氏は説明します。これにより、地域ごとではなく個別のニューロンが特定の標的に合わせられるかどうかを判断することができます。 MAPseqは、マーカー(典型的には蛍光タンパク質)がニューロンによって発現され、それらの軸索に沿って運ばれる、現在一般的に使用されているいわゆる「バルクトレーシング」方法とは異なる。このようなマーカーは、ソース領域のニューロンが投影されているすべての領域を決定するのに有効ですが、ソース領域の2つのニューロンが同じ領域、異なる領域、または同じ領域の一部に投影されていることを科学者に伝えることはできません。いくつかの異なるもの。与えられた領域内の細胞ごとのニューロンの軸索の目的地を解決することができないということは、ザドードルが新しい技術を生み出す動機となっています。

MAPseqのバルクトレース方法の利点を説明する1つの方法は、国際的な空港にいることを想像することです。たとえば、ドイツへの飛行を目的としています。 「国際線ターミナルに行くと、チケットカウンターが長く見えます。」とZador氏は説明します。 「ドイツに行くには、国際線ターミナルで航空会社を利用するだけでは不十分だ。もしあなたがエア・チリのカウンターに並んでいれば、おそらくドイツのチケットを買うことはできないだろう」

「カウンターが隣接している多くの航空会社は多くの目的地にサービスを提供していますが、その中のいくつかは重複していますが、その中にはユニークなものもあります。私の例の「個々の航空会社」は、「経路」を追求したい脳の部分の隣接ニューロンです。これは、現在のラベリング方法とMAPseqの違いです。 “ Zador氏とNeuronの論文の最初の著者であるJustus Kebschull氏は、新しい手法を導入した論文の著者であり、数年にわたり、数多くの人々に一意のバーコードのような識別子を割り当てる技術を開発しました。関心のある任意の脳領域における単回注射による個々のニューロンの使用。各注射は、個々にユニークなRNA分子の大規模なプールを含むように設計された不活性化ウイルスからなり、その各々の配列は、30個の「文字」またはヌクレオチドで構成され、個々のニューロンによって取り込まれる。 30文字はマウスや人間の脳のニューロンよりも何倍も多くのバーコード配列(1018)を生成するので、この方法は脳マッピングがもたらす複雑な問題に特に適しています。 脳の「供給源」領域への注射は、軸索経路に沿ってバーコードを運ぶように設計された遺伝子工学的タンパク質に突き当たる多様なバーコード配列をコードするウイルスライブラリーを含む。バーコードRNAは、高レベルで発現され、注入が行われるソース領域内の軸索の末端に輸送される。各ニューロンでは、軸索がシナプスを形成し、別のニューロンからの射影を形成する点まで移動する。テストでは、バーコードが軸索である「トランクライン」に沿って、そしてシナプスが形成される「分岐点」に沿って、脳全体に安定して均一に移動することが示されています。 関心領域で1回以上の注射が行われた約2日後、脳を切開し、RNAを収集し、配列決定する。 「ソース」領域のRNAバーコードは、現在、脳の遠隔部分で収集された同じバーコードと一致しています。

「RNAのシークエンシングは非常に効率的で自動化されたプロセスであり、MAPseqをこのような潜在的に根本的なツールにしている」とKebschull氏は語る。 「RNAシーケンシングのスピードと経済性に加えて、脳の異なる部位に投射する同じ領域内の個々のニューロンを区別することが可能になるという大きな利点があります。 MAPseqの能力を実証するために、Zadorのチームは、脳幹に位置する座骨核(LC)と呼ばれるマウス脳の一部を注射した。それはノルアドレナリンの唯一の皮質であり、驚きを知らせるホルモンです。 Zadorのチームは、MAPseqを使用して古い質問に対処しました。「驚き」信号は、皮質のあらゆる場所、またはおそらく最も必要とされる特定の場所にのみ放送されますか? 彼らの実証実験では、皮質または嗅球で終わったRNAのみが、バーコードが最初に注射されたLCのソース領域の配列と共に配列決定された。チームは、皮質を厚さ約300ミクロンの22個のスライスに分割し、スライスを解剖した。結果はチームにとってエキサイティングでした。 「LCのニューロンには、さまざまな特異な投影パターンがあることがわかりました。 「一部のニューロンは、皮質または嗅球の単一の好ましい標的にほぼ独占的にしか作用しないが、他のニューロンは、弱くはあるが、より広範に投射する」。 これらの結果は、LCの予測に関する以前の一見矛盾した結果と一致しており、和解していると付け加えています。驚きの信号は脳のほとんどの部分に到達することができますが、特に信号が集中している脳の非常に特殊な部分があります。

チームは、LCでの1回の注射、および反対側での2回の注射に基づく実験で結果が得られることを示した。すでに進行中であるのは、皮質全体が注射によって「タイル張り」されている実験です。このことが、単一ニューロン分解能で皮質全体の最初の結合部位を生じることが期待されている。 「多くの注射剤を使用するプロセスを自動化すれば、この種の実験はわずか1〜2週間で1人で完了でき、わずか数千ドルのコストで済むと考えています。 「我々は、単一の動物でこれらの研究を行うことができることに非常に熱心である。これは、複数のニューロンを追跡するために複数の動物を注射するという過去の問題を解消するものであり、そのうちのいくつかは多少異なっている。 MAPaseの次の目標は、さまざまな神経発達神経精神病モデルの動物の脳をマッピングして、因果関係に強く関連した遺伝子変異が脳回路の構造を変化させ、おそらく脳機能を変える方法を確認することです。

参考

Revolutionary method to map the brain at single-neuron resolution is successfully demonstrated

ディープラーニングチートシート

深層学習は、被験者に新しい時には圧倒的になることがあります。ここにいくつかのチートとヒントがあります。

何ですか?!?!

この記事では、このすばらしい主題を始めるためのディープラーニングの共通概念について説明します。

勾配∇(ナブラ)

勾配は、複数のベクトルをとり、単一の値(すなわちニューラルネットワークにおけるコスト関数)を出力する関数の偏微分である。 グラディエントは、変数入力を増やした場合、グラフをどの方向に移動して出力を増加させるかを指示します。 私たちは損失を減らしたいので、グラデーションを使用して反対方向に進みます。

逆伝播

バック・プロップとも呼ばれ、ネットワークを介して入力を順方向に伝播した後のネットワークの重みによるバック・トラッキングのプロセスです。 これは、微積分にチェーンルールを適用することによって使用されます。

シグモイドσ

[0、1]の間隔でネットワーク内の重みを有効にするために使用される関数。 この関数は、この関数が得られるところの ’S'のような形をしています。sはギリシャのsigmaです。 ロジスティック関数とも呼ばれる

整流された線形ユニットまたはReLU

シグモイド関数は[0,1]の間隔を持ち、ReLUは[0、無限大]の範囲を持ちます。 これは、シグモイドがロジスティック回帰の方が優れていることを意味し、ReLUは正の数を表現する方が優れています。 ReLUは、勾配の消失の問題を抱えていません。

Tanh

Tanhは[-1、1]のネットワークの重みを初期化するために使用される関数です。 データが正規化されていると仮定すると、より勾配が強くなります。データは0を中心としているため、デリバティブは高くなります。 これを見るには、tanh関数の導関数を計算し、入力値が[0,1]の範囲にあることに気づく。tanh関数の範囲は[-1,1]であり、シグモイド関数の範囲は[0,1 ]。 これはまた、グラジエントにおけるバイアスを回避する。

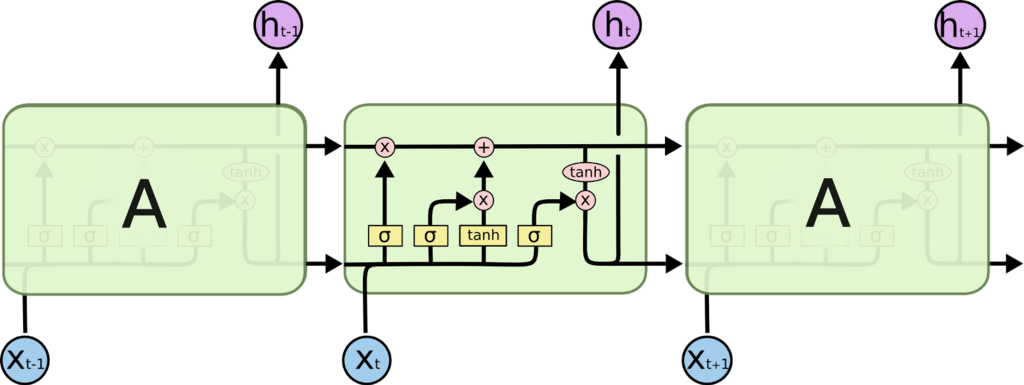

LSTM / GRU

リカレントニューラルネットワークでは一般的に見られるが、他のもので使用するように拡張されているものは、学習のための入力間の状態を維持し、約7時間後にRNNが事前入力の文脈を失う勾配勾配問題を解決するのに役立つ小さな「メモリユニット」である。

ソフトマックス

ソフトマックスは、通常、分類のためにニューラルネットワークの終わりに使用される機能です。 この関数は多項ロジスティック回帰を行い、一般に複数クラス分類に使用されます。 通常、損失関数としてクロスエントロピーと対になる。

L1とL2の正規化

これらの正則化方法は、係数にペナルティを課すことによって、オーバーフィッティングを防止する。 L1はスパースモデルを生成することができ、L2は疎モデルを生成することはできません。 正規化は、モデルの複雑さを指定するために使用されます。 これは、モデルが一般化してトレーニングデータに余裕がないようにするため、重要です。

ドロップアウト

[1]「過剰適合を防ぎ、指数関数的に多くの異なるニューラルネットワークアーキテクチャを効率的に組み合わせる方法を提供する」(Hinton)このメソッドは、可視および隠れユニットをランダムに選択してネットワークから削除します。これは、通常、レイヤの割合のドロップアウトを選択することによって決定されます。

バッチ正規化

[1]ネットワークに深い層が多い場合、内部共変量シフトの問題が発生します。移行は「トレーニング中のネットワークパラメータの変化によるネットワークアクティベーションの分布の変化」です(Szegedy)。内部の共変量シフトを減らすことができれば、より速くより良い訓練をすることができます。バッチノーマライゼーションは、各バッチを平均と分散の両方でネットワークに正規化することによってこの問題を解決します。

目的関数

ロス関数、コスト関数またはオプティマイゼーションスコア関数とも呼ばれます。ネットワークの目標は、損失を最小限に抑えてネットワークの精度を最大限に高めることです。 より技術的な説明[3]: 損失/コスト/最適化/目的関数は、ネットワークの予測で計算される関数です。あなたのネットワークは、yの期待される出力と比較する予測y_hatを出力します。この関数はバックプロパゲーションで使用され、ネットワークを最適化するためのグラディエントを与えます。これらの関数の例は、f1 / fスコア、カテゴリクロスエントロピー、平均二乗誤差、平均絶対誤差、ヒンジ損失…などです。 F1 / Fスコア 次の式に従って精度とリコールを使用して、モデルがどれほど正確であるかの尺度です。

F1 = 2 * (精度 * 想起) / (精度 + 想起)

正確:どの予測が実際にポジティブであるかの予測はどれですか?

精度=真陽性/(真陽性+偽陽性)

想起:すべての実際に正の憶測を持っている実際にどの部分が肯定的でしたか?

リコール=真陽性/(真陽性+偽陰性)

クロスエントロピー

あなたのラベル予測がどのくらい離れているかを計算するために使用されます。 CEで示される時代。

クロスエントロピーは損失関数であり、エントロピーの概念である熱力学のエントロピーに関連している。 これは、多クラス分類で、予測のエラーを見つけるために使用されます。

学習率[2]

学習率は、バックプロパゲーション後の最適化中にネットワークのウェイトを調整する度合いです。 学習率は、さまざまな問題で異なる超パラメータです。 これはクロスバリデーションを行う必要があります。

# ---- Vanilla Gradient Descent ---- # W is your matrix of weights # dW is the gradient of W # Adjust the weights of our layer by multiplying our gradient times our learning_rate (Which is a scalar value) W -= learning_rate * dW

参考

https://hackernoon.com/deep-learning-cheat-sheet-25421411e460#.unr1u76fq

株式市場を深層学習する

コードはこっち https://github.com/talolard/MarketVectors/blob/master/preparedata.ipynb

ここ数ヶ月、私は “ディープラーニング"、特に言語とテキストへのそのアプリケーションに魅了されました。私は大部分の経歴を金融技術に費やしました。主にアルゴリズム取引や代替データサービスでした。これがどこにあるのかを見ることができます。 私はこれを書いて私の考えを真っ直ぐにしました。私は「ディープ・ラーニング」の愛好家になっていますが、頭がおかしいほどの栄光の中でアイデアを脳ダンプする機会はあまりありません。私は、明確な考え方の適切な表示は、現場からではなく人々にそれを明言する能力であると私は思う。私はそれを行うことに成功したことを願っています。私の表現は楽しいものです。

NLPが株式予測に関係する理由

多くのNLP問題では、シーケンスをとり、それを単一の固定サイズ表現にエンコードし、その表現を別のシーケンスにデコードします。たとえば、テキスト内のエンティティにタグを付けたり、英語からフランス語に翻訳したり、オーディオの頻度をテキストに変換することができます。これらの分野では激しい作業が行われており、多くの結果が最先端のパフォーマンスを達成しています。 私の考えでは、NLPと財務分析の最大の違いは、言語に構造の保証があることです。構造の規則があいまいであることだけです。一方、市場は学習可能な構造の約束を持っておらず、そのような構造は、このプロジェクトが証明または反証されることを前提としています(その構造を見つけることができれば、 その構造が存在すると仮定すると、パラグラフのセマンティクスをエンコードするのと同じ方法で市場の現在の状態を要約するという考えは私にとっては妥当であると思われます。まだそれが理にかなっていない場合は、読んでください。そうなる。

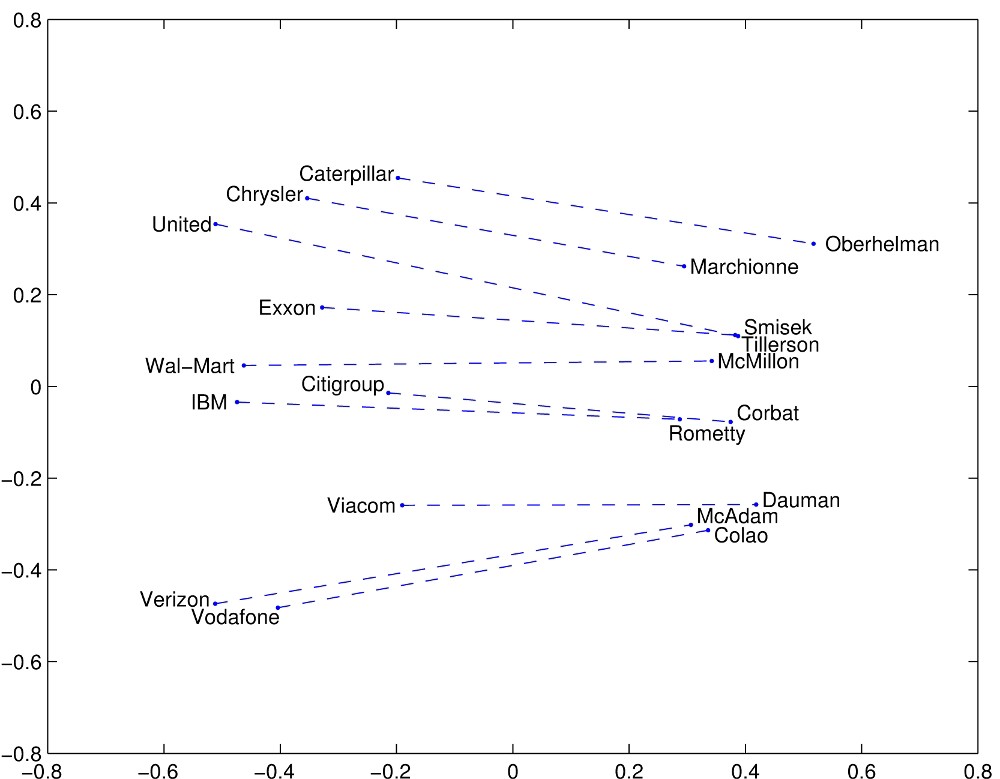

あなたはそれが保持している会社の言葉を知っているはずです(Firth、J. R. 1957:11) 単語の埋め込みに関する文献はたくさんあります。 Richard Socherの講義は素晴らしいスタート地点です。 一言で言えば、我々はすべての言葉の幾何学を私たちの言語で作ることができ、その幾何学は言葉の意味とそれらの間の関係を捕らえる。 あなたは “キングマン+女性=クイーン"のような例を見たことがあります。

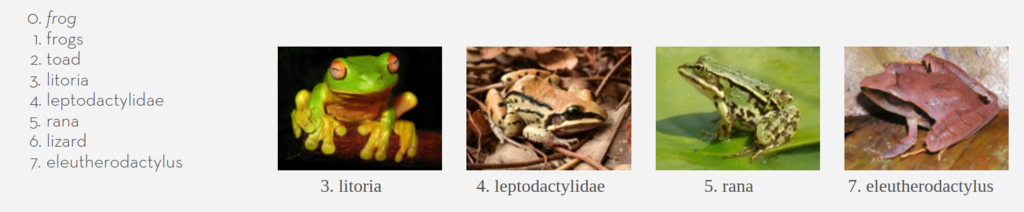

埋込みは凝縮された形で情報を表現できるので、すばらしいです。 単語を表現する古い方法は、私たちが知っている単語の数と同じ長さのベクトル(数字の大きいリスト)を保持し、それが現在の単語であれば特定の場所に1を設定していました。 これは効率的なアプローチではなく、意味を捉えません。 埋め込みを使用すると、固定された数のディメンション内のすべての単語を表現することができます(300は十分であるように見える、50はうまくいく)。 下の図は例を示しています。 埋め込みはインターネット全体で多かれ少なかれ訓練されました。 集中的な計算の数日後に、各単語はいくつかの高次元空間に埋め込まれていました。 この「空間」にはジオメトリや距離などの概念があり、どの単語が近いかを尋ねることができます。 その方法の著者/発明者が例を挙げた。 カエルに最も近い言葉があります。

しかし、我々は単なる言葉以上のものを組み込むことができます。 我々は、例えば、株式市場埋め込みを行うことができます。

Market2Vec

私が聞いた最初の単語埋め込みアルゴリズムはword2vecでした。 別のアルゴリズムを使用していますが、私は市場で同じ効果を得たいと思います。 私の入力データはcsvで、最初の列は日付で、1,000株のHigh Low Open Closingの価格に対応する4 * 1000の列があります。 それは私の入力ベクトルが大きすぎる4000次元です。 だから私がやるべきことの最初のことは、私が映画が好きだったので、それをより低い次元の空間、例えば300に埋め込むことです。

4000次元で何かを撮り、それを300次元空間に詰め込むのは私の音ですが、実際には簡単です。 行列を乗算するだけでいいです。 マトリックスは、すべてのセルに数値を持ち、フォーマットに問題がない、優れたExcelスプレッドシートです。 4000列と300行のExcelテーブルを想像してみましょう。そして、基本的にベクトルに対してそれを打つと、サイズ300の新しいベクトルが出てきます。それが大学でどのように説明したのかと思います。

ここでは、マトリックスの数値をランダムに設定するので、ここでは始まります。「深層学習」の一部は、スプレッドシートが変わるように数値を更新することです。結局、この行列スプレッドシート(私は今からマトリックスに固執するでしょう)には、元の4000次元のベクトルをそれ自身の簡潔な300次元の要約に叩き込む数が入ります。 私たちはここでちょっと気晴らしをして、活性化機能と呼ばれるものを適用します。我々は関数を取り、それをベクトルの各番号に個別に適用して、それらがすべて0と1の間で終わるようにします(または、0と無限大、それは依存します)。どうして ?これは私たちのベクトルをより特別なものにし、学習プロセスがより複雑なものを理解できるようにします。どうやって? だから何?私が見いだしたいことは、市場価格(ベクトル)を小さなスペースに新たに埋め込むことは、他のものに時間を浪費することなく、手元にあるタスクのすべての重要な情報をキャプチャすることです。だから、私は彼らが他の株式との相関関係を捉えると期待しています。おそらく、あるセクターが衰退しているときや市場が非常に暑いときに気付くでしょう。私はそれがどのような特徴を見つけるのか分からないが、彼らは役に立つと思う。

それで

私たちの市場ベクタを脇に置き、言語モデルについて話してください。 Andrej Karpathyは、叙事詩「リカレントニューラルネットワークの不合理な有効性」を書きました。私が最もリベラルな方法で要約すれば、ポストは

- 私たちがシェイクスピアの作品を見てキャラクターごとに登場すれば、「深層学習」を使って言語モデルを学ぶことができます。

- 言語モデル(この場合)は魔法の箱です。あなたは最初の数文字を入れて、次の文字が何になるかを教えてくれます。

- 言語モデルが予測した特性を取り入れ、それを元に戻すと、私たちは永遠に続くことができます。

そして、パンチラインとして、彼はシェイクスピアのようなテキストの束を生成しました。そして、彼はLinuxのソースコードでそれをやり直しました。それから再び代数幾何学に関する教科書で。

だから、私はそのマジックボックスのメカニックに戻ってきますが、前のものに基づいて次の言葉を予測したように、過去の市場を予測したいと思います。 Karpathyが文字を使用する場所では、マーケットベクトルを使用して魔法のブラックボックスに入力します。 私たちはまだ予測したいものを決めていませんが、それは大丈夫です。

より深く進む

私は、深層学習の深い部分に取り掛かるところがここにあることを指摘したいと思います。 これまでのところ、市場を凝縮させるスプレッドシートを凌駕する学習の単層があります。 ここで、いくつかのレイヤーを追加して積み重ねて、「深い」ものを作ります。 それは深層学習の深いところです。 だからKarpathyは、Linuxソースコードからのサンプル出力を示しています。これは、ブラックボックスが書いたものです。

static void action_new_function(struct s_stat_info *wb)

{

unsigned long flags;

int lel_idx_bit = e->edd, *sys & ~((unsigned long) *FIRST_COMPAT);

buf[0] = 0xFFFFFFFF & (bit << 4);

min(inc, slist->bytes);

printk(KERN_WARNING "Memory allocated %02x/%02x, "

"original MLL instead\n"),

min(min(multi_run - s->len, max) * num_data_in),

frame_pos, sz + first_seg);

div_u64_w(val, inb_p);

spin_unlock(&disk->queue_lock);

mutex_unlock(&s->sock->mutex);

mutex_unlock(&func->mutex);

return disassemble(info->pending_bh);

}

かっこを開いたり閉じたりする方法を知っており、インデントの規則を尊重していることに注意してください。関数の内容は適切にインデントされており、複数行のprintkステートメントは内側の字下げを持っています。これは、このマジックボックスが長距離依存性を理解していることを意味します。 print文の中にインデントされているときは、それがprint文にあることを知っていますし、関数内にあることも記憶しています(少なくともインデントされた他のスコープも)。それはナッツです。それを光栄にするのは簡単ですが、長期依存性を捕捉して記憶する能力を持つアルゴリズムは非常に有用です。なぜなら、我々は市場で長期依存性を探したいからです。

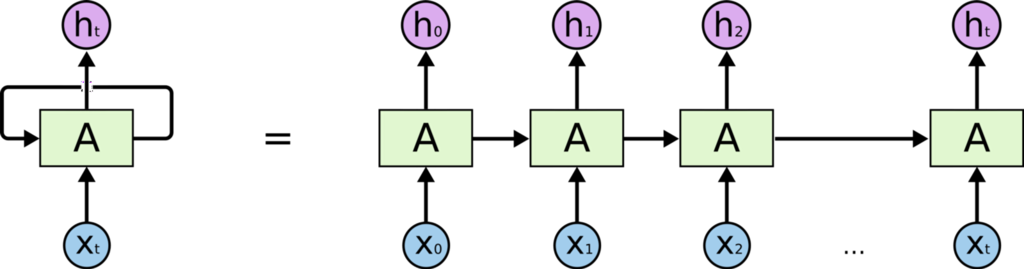

魔法のブラックボックスの中に

この魔法のブラックボックスの中身は何ですか?これは、LSTMと呼ばれるリカレントニューラルネットワーク(RNN)の一種です。 RNNは、シーケンス(文字列のような)に作用する深層学習アルゴリズムです。すべてのステップで、次のキャラクタの表現(前に述べた埋め込みのように)を取り、前に見たようにマトリックスで表現します。問題は、RNNに何らかの形の内部メモリがあるため、以前に見たものを記憶していることです。そのメモリを使用して、次の入力でどのくらい正確に動作するかを決定します。そのメモリを使用して、RNNは意図したスコープの内側にあることを「覚えている」ことができます。これは、適切にネストされた出力テキストを取得する方法です。

RNNの華麗なバージョンをLong Short Term Memory(LSTM)といいます。 LSTMは巧みに設計されたメモリで、 - それが覚えているものを選択的に選択する - 忘れることを決める - どのくらいのメモリを出力するかを選択します。

だから、LSTMは “{"を見て "それを覚えておくことが大事です"と言うと、それがネストされた範囲にあることを本質的に覚えています。対応する ”}“が見えると、元の開きブレースを忘れて、それがネストされたスコープにあることを忘れることができます。 私たちは、LSTMにいくつかを重ねることでより抽象的な概念を学ばせることができます。それによって、私たちは再び「深く」なります。以前のLSTMの各出力は、次のLSTMの入力となり、入力されるデータの抽象度を上げることができます。上の例では(これは単なる推論です)、LSTMの最初の層はスペースで区切られた文字は「単語」です。次のレイヤーは、(static void action_new_function)のような単語タイプを学習するかもしれません。次のレイヤーは、関数とその引数の概念などを学ぶかもしれません。 Karpathyのブログは、どのようにして正確にそれを可視化したのか、本当に素晴らしい例がありますが、各レイヤーが何をしているのかを正確に伝えるのは難しいです。

Market2VecとLSTMの接続

熟練した読者は、Karpathyが埋め込みではなく文字を入力として使用していることに気付くだろう(技術的には文字のワンホットエンコーディング)。しかし、Lars Eidnesは実際には、リカレントニューラルネットワークを使用してClickbaitを自動生成するときに単語埋め込みを使用しました

上記の図は、彼が使用したネットワークを示しています。 SoftMaxの部分は無視してください(後で説明します)。今は、一番下の単語の並びとそれぞれの単語の並びの中に、どのように底を置いているのかをチェックしてください。 (「単語ベクトル」は、この記事の冒頭で見たように、数字の束の形の単語の表現であることを忘れないでください)。 Larsは一連の単語ベクトルとそれらのそれぞれを入力します: - 最初のLSTMに影響する - LSTMを上のLSTMに何か出力する - LSTMを次の単語のためにLSTMに何か出力させる 1つの違いで同じことをやろうとします。単語ベクトルではなく、 “MarketVectors"を入力します。要約すると、MarketVectorsには、特定の時点における市場で起こっていることの概要が含まれている必要があります。それらのシーケンスをLSTMに挿入することで、市場で起こっている長期的な動向を把握したいと考えています。 LSTMのいくつかのレイヤーを積み重ねることで、私はマーケットの振る舞いのより高いレベルの抽象を捕捉したいと考えています。

何が出てくるのか

これまでのところ、アルゴリズムが実際に何かを学ぶ方法については一切言及していませんでしたが、私たちはデータで行う巧妙な変換について話しました。その会話をいくつかの段落に延期しますが、他のすべてのものを価値のあるものにするパンチラインのために、この部分を覚えておいてください。 Karpathyの例では、LSTMの出力は、ある抽象表現の次の文字を表すベクトルです。 Eidnesの例では、LSTMの出力は、次の単語が何らかの抽象空間内にあることを表すベクトルです。両方の場合の次のステップは、抽象的な表現を確率ベクトルに変更することです。確率ベクトルは、それぞれの文字または単語がそれぞれ次にどのように表示される可能性が高いかを示すリストです。これがSoftMax機能の仕事です。尤度のリストを取得したら、次に表示される可能性の高い文字または単語を選択します。 「市場を予測する」という我々のケースでは、予測するために市場に出たいと思っているものは何かを自問する必要があります。私が考えていたオプションのいくつかは:

1、1000株のそれぞれの次の価格を予測する 2、次のn分にあるインデックス(S&P、VIXなど)の値を予測します。 3、次のn分で株式のどれがx%以上上昇するかを予測する 4、(私の個人的な好み)次のn分に2倍の割合でどの株が上下するかを予測し、その間にx%以上下がることはありません。 5、(この記事の残りの部分ではこれから説明する予定です)。 VIXが次のn分で2倍の割合で上/下に移動し、その間にx%以上下降しないと予測します。

1と2は回帰の問題で、特定のイベント(文字nの出現や市場の上昇のような)の可能性ではなく、実際の数を予測する必要があります。 それらは大丈夫ですが、私がしたいことではありません。 3と4はかなり似ていますが、どちらもイベントを予測するように求められます(技術用語ではクラスラベル)。 イベントは、次に表示される文字nとすることもできますし、過去10分間に3%以上ダウンしないで5%を上げることもできます。 3と4との間のトレードオフは、3がはるかに一般的であることから学ぶことがより簡単であり、4は利益の指標であるだけでなくリスクにいくつかの制約があるため、価値が高いということです。 5は、3と4に似ているが、従うのが簡単な仕組みを持っているので、この記事では引き続き説明します。 VIXはFear Indexと呼ばれることもあり、S&P500の株式がどれほど変動するかを表します。 これは、指数内の各株式に関する特定のオプションのインプライド・ボラティリティを観察することによって導出されます。

Sidenote - なぜVIXを予測するのか

VIXを興味深いターゲットにするのは、 1000年代の株式ではなく、1つの数字だけです。これにより、概念的に従うのがより簡単になり、計算コストが削減されます。 それは多くの株式の要約なので、入力のすべてではないにしてもほとんどが関連している 入力の線形結合ではありません。インプライドボラティリティは、複雑で非線形のフォーミュラ在庫から在庫によって抽出されます。 VIXは、その上に複雑な数式から派生しています。私たちがそれを予測できるなら、それはかなりクールです。 それはトレード可能なので、実際にこれが動作すれば使用できます。

私たちのLSTM出力とSoftMaxに戻る

将来VIXの変更を予測するために、以前に見た公式をどのように使用すればよいでしょうか?データセットの各ポイントについては、5分後にVIXに何が起こったかを見ていきます。その時間に0.5%以上下がることなく1%以上上がった場合は、1を出力し、それ以外の場合は0を出力します。次に、次のようなシーケンスが得られます。

0,0,0,0,0,1,1,0,0,0,1,1,0,0,0,0,1,1,1,0,0,0,0,0 …。

私たちは、LSTMが出力したベクトルを取り込み、シーケンスの次のアイテムの確率が1になるようにスカイシングしたいと思っています。スケーリングは、上の図のSoftMaxの部分で行われます。 (技術的には、現在1クラスしかないので、シグモイドを使用しています)。

だから私たちがこのことを学ぶ前に、今まで何をしてきたのかを見直そう 我々は1000株の価格データのシーケンスを入力として取る 順序の各時点は市場のスナップショットです。私たちの入力は4000の数字のリストです。埋め込みレイヤーを使用して、300の数字で重要な情報を表現します。 今我々は市場の埋め込みのシーケンスを持っている。それらをLSTMのスタックに入れます。タイムステップごとにタイムステップを進めます。 LSTMは前のステップからの事柄を覚えており、それは現在のプロセスをどのように処理するかに影響します。 LSTMの最初の層の出力を別の層に渡します。これらの人たちはまた覚えて、私たちが入れた情報のより高いレベルの抽象を学ぶ。 最後に、すべてのLSTMからの出力を取り込み、市場情報のシーケンスが一連の確率になるように「スキッシュ」します。問題の確率は、「VIXが0.5%下がることなく次の5分で1%上昇する可能性がある」 このことはどうやって学ぶのですか? 今楽しい部分。今まで私たちがやったことは全て順路と呼ばれていましたが、私たちはアルゴリズムを訓練する間に、またそれらを生産に使用するときに、すべてのステップを実行します。ここでは、逆方向パスについて説明します。私たちのアルゴリズムを学習させる訓練中に行う部分だけです。 そのため、トレーニング中に過去数年間の歴史的データを準備しただけでなく、データの各観測後にVIXが希望の方法に移動したかどうかを示す0と1のリストも作成しました。 学習するには、市場データをネットワークに送り、その出力を計算したものと比較します。私たちの場合を比較すると、簡単な減算になります。つまり、モデルの誤差は次のようになります。 ERROR =(((事前計算) - (予測確率))²)^(1/2) または英語では、実際に起こったことと私たちが予測したことの差の平方根の平方根です。

ここに美しさがあります。これは微分関数です。つまり、予測が少し変わった場合、誤差がどのくらい変化したかを知ることができます。我々の予測は、微分可能な関数の結果である。SoftMax softmaxへの入力であり、LSTMはすべて微分可能な数学関数である。これらの関数はすべてパラメータでいっぱいですが、私が以前に話したような大きなスプレッドシートです。ですから、この段階では、私たちがモデルで持っているすべてのExcelスプレッドシートの何百万というパラメータのすべてについて、エラーの派生を取ります。これを実行すると、各パラメータを変更したときにエラーがどのように変化するかを見ることができるので、エラーを減らす方法で各パラメータを変更します。 このプロシージャは、モデルの先頭まですべて伝播します。マーケットベクトルが私たちの仕事にとって最も重要な情報を表すように、マーケットベクトルにインプットを埋め込む方法を微調整します。 それぞれのLSTMがいつ覚えているかを微調整し、出力が仕事に最も関連するようにします。 私たちのLSTMが学ぶ抽象を調整して、私たちの仕事にとって最も重要な抽象概念を学ぶようにします。 これは、われわれがどこにも指定する必要のないこのような複雑さと抽象をすべて持っているので、私の意見では驚くべきことです。 MathaMagically私たちがエラーとみなすものの仕様から推測されます。

次は何ですか

今私はこれを書面で明らかにしたが、それでも私は欲しいと思う。 誰かがこれを読むのを邪魔するかどうかを確認する。 親愛なる読者が指摘している間違いをすべて修正する これがまだ実現可能かどうかを検討する そしてそれを構築する あなたがこれまで来たのであれば、間違いを指摘し、あなたの意見を共有してください。

他の考え

ここでは、このプロジェクトに関するいくつかのより高度な考え方、私が試してみたいこと、それが実際にうまくいくかも知れない理由が私には分かります。

資本の流動性と効率的利用

一般的に、特定の市場がより流動性が高いほど効率的です。私はこれが鶏肉と卵のサイクルによるものだと考えていますが、市場はより流動的になりますが、資本がそれ自体を傷つけずに出入りする資本を吸収することができます。市場が流動的になり、資本を増やすにつれて、洗練されたプレーヤーが入居することになります。これは洗練された費用がかかり、大規模な資本でリターンする必要があるためです。運用コストを正当化します。 迅速な結果は、流動性の低い市場では、競争はそれほど洗練されていないので、このようなシステムが取引できる機会はないと考えられます。要点は私が試してこれを試してみることでした。それは市場の液状ではない部分、つまりおそらくS&P 500の代わりにTASE 100で試すことです。

このことは新しいものです

これらのアルゴリズムの知識、それらを実行するためのフレームワーク、それらを訓練するコンピューティングパワーは、少なくとも自分自身のような平均的なJoeに利用可能であるという意味では全く新しいものです。私は、トッププレーヤーが数年前にこのようなことを考え出し、長い間実行する能力を持っていたと仮定したいと思いますが、上の段落で言及したように、彼らはそのサイズをサポートできる液体市場で実行する可能性が高いです。市場参加者の次の層は、技術的な同化の速度が遅く、その意味で未開拓の市場でこれを実行しようとする競争があるか、またはすぐになると思います。

複数のタイムフレーム

私は上記の1つのインプットの流れについて述べましたが、私は、効率的なトレーニング方法は、市場のベクトルを(少なくとも)複数の時間枠で訓練し、推論段階でそれを供給することだと思います。つまり、私の最低時間フレームは30秒ごとにサンプリングされ、ネットワークは最大でも時間を伸ばす依存関係を学習すると期待しています。 彼らが適切かどうかはわかりませんが、複数の時間枠にパターンがあると思います。計算コストを十分に低く抑えることができれば、それらをモデルに組み込むことは価値があります。私はまだ計算上のグラフ上でこれらを表現するのが最善の方法と対立しており、おそらくそれを開始することは必須ではないかもしれません。

MarketVectors

NLPで単語ベクトルを使用するときは、通常、事前にトレーニングされたモデルから始め、モデルのトレーニング中に埋め込みの調整を続けます。私の場合は、事前に訓練された市場のベクトルはありませんし、またそれらを訓練するための明確なアルゴリズムもありません。 私の元々の考察は、この論文のように自動エンコーダーを使用することでしたが、終了までのトレーニングはよりクールです。 より深刻な考慮点は、シーケンスが最終的に単一のベクトルとして符号化され、次いで異なる表現(音声からテキストまたは英語からフランス語のような)に復号される、翻訳および音声認識におけるシーケンス間シーケンスモデルの成功である。その見方では、私が記述したアーキテクチャ全体は基本的にエンコーダであり、実際にはデコーダを配置していません。 しかし、私は最初のレイヤー、つまり4000次元のベクトルを入力として取り、300次元のものを出力するレイヤーに特有のものを実現したいと考えています。私はそれがさまざまな株式間の相関や関係を見つけて、それらに関する特徴を構成したいと思っています。 代わりに、各入力をLSTMを介して実行し、おそらくすべての出力ベクトルを連結し、エンコーダステージの出力を考慮する。私は、楽器とその機能の間の相互作用や相関関係が失われ、10倍の計算量が必要になるため、これは非効率的だと思います。一方、そのようなアーキテクチャは、複数のGPUとホスト間で単純に並列化することができ、これが利点です。

CNNs

近年、文字レベルの機械翻訳に関する論文が盛んになっている。このホワイトペーパーでは、RNNではなく畳み込みレイヤーを使用して、長距離の依存関係をキャプチャできるようになったので、私の目には惹かれました。私はそれを短く読まれた以上のものではありませんでしたが、私は、各株をチャネルとして扱い、最初に(RGBイメージのように)チャネルを畳み込む改造は、市場のダイナミックスを本質的に文字から意味的意味を符号化するのと同じ方法である。

参考

https://medium.com/@TalPerry/deep-learning-the-stock-market-df853d139e02#.gk4f2pc1i

AIの冬は来てないです

アンドリュー先生の意見は完全に冬になることはないという意見。 納得感がある。量子化とかが進めばまた新しいアルゴリズムが試せるようになるのでしょう。

人工知能はすべて目覚ましいものであり、目まぐるしいペースで発表される見込みのある進歩と、AIチームをできるだけ早く構築している企業です。

ブームは続くことができますか?

Baidu Researchのチーフ・サイエンティストAndrew Ngは、機械学習とAIの分野における主要な人物であり、コンピューター・プロセッサー設計の改良により、予測可能な将来に向けてパフォーマンスの進歩と画期的な進歩が維持されると述べています。 Ng氏は、「複数の[ハードウェアベンダー]がロードマップを分かち合うほど親切であった」と語る。 「私は彼らが信用できると確信しており、今後数年間でより多くの計算能力とより高速なネットワークを得ることができます」

AIの分野は、急速な進歩と誇大宣伝の段階を経て、すぐに続いて「AI冬」と呼ばれることが多い投資や関心が急速に低下しました。最初の寒気は1970年代に起こりました。干上がる;最新の傾向が期待される商業的影響を受けなかったため、1980年代に打撃を受けた別の人がいました。

それでは、おそらく、現在のものと一致するブームはありませんでした。商業的に重要なブレークスルーが続くと仮定して研究チームを構築するにつれて、人工知能研究者は基礎研究を行うために巨額の賃金を提供されている。

近年の進歩は、強力な「ディープ・ラーニング」システム(「10ブレイクスルー・テクノロジーズ2013:ディープ・ラーニング」を参照)の開発によってもたらされました。 数年前から、非常に大きな、または深層ニューラルネットワークを、ラベル付きの例を使って訓練して、人間のような正確さであらゆる種類のものを認識できることを発見しました。 これにより、画像や音声認識などの面白い進歩がもたらされました。

Ngはこれらのシステムがより強力になるとしか言いません。 これにより、既存の深層学習ツールの精度が向上するだけでなく、構文解析や言語生成などの新しい分野で技術を活用できるようになります。

Ng氏によると、ハードウェアの進歩は、新興のAI技術を実現可能にするために必要な燃料を提供します。

「パフォーマンスが10倍向上すれば、私が好きな実験はたくさんあります」とNg氏は付け加えます。たとえば、さまざまな画像処理アルゴリズムを使用する代わりに、コンピュータのパワーを高めることで、あらゆる種類の画像関連タスクを実行できる単一のアルゴリズムを構築できる可能性があるという。

今週、バルセロナで開催された世界のAI専門家が、ニューラル・インフォメーション・プロセッシング・システムズ・カンファレンスと呼ばれる有名なイベントを開催しました。数年前の数百人から今年にかけて6,000人以上に増えたこの集まりの規模は、人工知能に大きな関心を寄せていることを示しています。

「誇大宣伝は間違いない」とNg氏は付け加えた。「しかし、これまでのように崩壊することのない、本当の価値の強力な根底にあるドライバがあると思う」

Salesforceのチーフ・サイエンティスト、機械学習と言語に関する有名な専門家であるRichard Socherは、機械学習アルゴリズムの進歩と相まって、膨大な量のデータを利用できるようになり、進歩を続けると述べています。

Salesforceは、営業リードを管理するためのクラウドツールと、顧客とのコミュニケーションを提供します。同社のAIの取り組みは、SocherのスタートアップMetamindを今年初めに買収した後に形作られた。 Salesforceは現在、画像認識システムなどの企業にシンプルな機械学習ツールを提供しています。

今まで、機械学習は消費者空間の大手企業によって実証されてきたとSocherは述べています。このような技術をより広く利用できるようにすることは、大きな影響を与える可能性がある、と彼は言う。 「Salesforceを使用している15万社の企業が機械学習を通じて効率を1%向上させるとすれば、文字通り米国のGDPで見ることになります。

Socherは、産業界における機械学習の応用は、しばらくの間、AIへの関心を維持すると考えています。 「AIの冬はこれまでの冬ほど寒いかもしれないとは想像もできません。

参考

https://www.technologyreview.com/s/603062/ai-winter-isnt-coming/